Co oznacza „Augmented Reality”, czym jest, kiedy powstała i dlaczego Siemens, uznany producent rozwiązań CAD/CAM/CAE & PDM/PLM, w swoich materiałach prasowych uczynił z niej jeden z głównych atutów najnowszej wersji systemu Solid Edge?

Autor: Maciej Stanisławski

Początki współcześnie rozumianej rzeczywistości rozszerzonej (ang. Augmented Reality) sięgają lat 60. XX wieku i wiążą się z nazwiskiem rozpoznawalnym przez wszystkim pasjonatów komputerowych programów wspomagających projektowanie. To właśnie prace badawcze Ivana Sutherlanda i opracowane przez niego pierwsze rozwiązania wyewoluowały do postaci obecnie znanych i coraz powszechniej stosowanych systemów. Ivan Sutherland nie tylko stworzył pierwszy CAD („Sketchpad” – proszę nie mylić z systemem kojarzonym współcześnie z Google), ale także pierwsze okulary do rzeczywistości wirtualnej.

To także on w swoim eseju z 1965 roku pt. „The Ultimate Display” zawarł sformułowania opisujące nie tylko założenia VR (ang. Virtual Reality), ale także AR. Pisał w nim m.in.:

„(…) Ekran ma się stać okularami do podglądania cudownego świata matematycznego odwzorowania rzeczywistości istniejącej

(tłum. CADblog.pl)

w pamięci komputera, oddziaływać na jak najwięcej zmysłów.

Jak dotąd nic nie wiem o urządzeniach pozwalających na symulowanie, oddawanie smaku i zapachu. Ale dysponujemy znakomitym sprzętem audio, chociaż muzyka i dźwięki generowane przez komputer nie są jeszcze porywające. Możemy natomiast kontrolować siły odczuwane przez użytkownika posługującego się komputerowymi manipulatorami, joystickami etc. (…)

Nie ma powodu, dla którego obiekt generowany przez komputer musiałby zawsze i bezwzględnie podlegać prawom fizyki realnego świata. W ten sposób bryła, obiekt, model, na życzenie użytkownika mógłby stać się przezroczysty, aby można było zajrzeć do jego wnętrza lub patrzeć przez niego.

(…) Ostateczną (najdoskonalszą – przyp. red) formą wyświetlacza mogłoby być pomieszczenie, w którym komputer mógłby kontrolować materię i prawa fizyki. Krzesło ustawione w takim pomieszczeniu byłoby wystarczająco solidne (realne), aby można było w nim usiąść (…), a pocisk na tyle niebezpieczny, by zabić.”

Wspomniałem o pierwszych okularach, czy może raczej goglach do VR. Trzy lata po napisaniu powyższego eseju Sutherland ukończył pierwszy wyświetlacz, który można było nosić na głowie. Nie był to jednak typowy „hełm” – ze względu na swoją wagę urządzenie musiało być dodatkowo podwieszone pod sufitem, co ograniczało w istotny sposób sowobodę użytkownika i… przyczyniło się do nadania owemu wyświetlaczowi nazwy „Miecz Damoklesa”. Ale chociaż obecnie wyświetlacz ten może wydawać nam się prymitywny, to pozwalał już zarządzającemu nim systemowi śledzić ruchy głowy użytkownika i na nie odpowiednio reagować, miał także przezroczystą optykę – a ta umożliwiała łączenie obrazów komputerowych z rzeczywistym tłem. A właśnie na łączeniu cyfrowego obrazu z rzeczywistością polega rozszerzona rzeczywistość.

Po co wymyślono AR?

Główną zaletą Augmented Reality jest nie tylko wyjście poza standard 2D, czy nawet modelowanie 3D – gdy model wyświetlany jest na ekranie 2D i korzystanie z niego wiąże się z wszystkimi ograniczeniami wynikającymi z pracy z płaskim odwzorowaniem; możliwość oglądania modelu „naprawdę 3D” oferują nam już rozwiązania z obszaru VR. Ale to rozszerzona rzeczywistość pozwala na połączenie wirtualnego modelu 3D z realnym światem, realnym otoczeniem. Brakujący nowo projektowany detal, element, podzespół, możemy dopasować nie tylko jako model 3D do już istniejącego innego cyfrowego odwzorowania, ale można go niemalże namacalnie umieścić w już istniejącym fizycznie obiekcie, w jego „kontekście”. I jeśli przy tym wszystkim owo narzędzie, rozwiązanie AR nie pozostanie jedynie zaawansowaną „przeglądarką plików, modeli 3D”, ale pozwoli na edycję modelu w czasie rzeczywistym, zachowując jego pełną asocjatywność ze środowiskiem systemu CAD (w którym ów model pierwotnie powstał) – to wtedy istotnie możemy mowić o małej rewolucji w dziedzinie projektowania. I będzie to coś więcej nawet niż wspomniane w eseju Sutherlanda „widzenie przez materię”.

Tak się właśnie dzieje. Wspierana przez rozwój nowoczesnych technik informatycznych i komputerowych rozszerzona rzeczywistość wydaje się nabierać szczególnego znaczenia we współczesnych procesach projektowych. I nie jest to tylko wrażenie potęgowane np. modą na nowe zaawansowane techniki; wiele świadczy o tym, że rozszerzona rzeczywistość istotnie ma wpływ na projektowanie/cykl życia produktu.

– Czy w najbliższych latach jej zastosowanie może zdominować i w efekcie zmienić sposób pracy nad projektem, nad nowym produktem, czy może AR na stałe wpisze się do grona rozwiązań komplementarnych, uzupełniających i wspierających proces produktowy? – zastanawia się redaktor Tom Kevan na łamach portalu digitalengineering247.com (dawniej DeskEng – przyp. autora). Cóż, jeśli dojdzie do wspomnianej asocjatywności z wyjściowym modelem CAD, jeśli poprzez interakcję w środowisku AR użytkownik będzie mógł edytować, modelować, słowem – pracować w środowisku CAD 3D, to z pewnością. Chociaż nie można zapomnieć o jeszcze jednym, istotnym czynniku – potrzebne jest zapotrzebowanie na AR ze strony potencjalnych użytkowników.

Zanim firmy zaadaptują rozwiązania AR i wybiorą system CAD/CAM/CAE pozwalający na korzystanie z jej niewątpliwych zalet, muszą zrozumieć, co ta technologia oferuje. Sprawdzić jej praktyczną skuteczność i ocenić, czy korzyści wynikające z jej użycia zrównoważą wydatek finansowy i czasowy potrzebny na jej poznanie i wdrożenie.

„Kupujemy oczami”

Jakże często wizualizacja ma kluczowe znaczenie przy podejmowaniu ostatecznych decyzji odnoszących się do „być albo nie być” nowego projektu. Każde dodatkowe narzędzie pozwalające na przeniesienie wizualizacji na jeszcze wyższy poziom w naturalny sposób poprawia komfort pracy nad projektem. O ile VR pozwala „jedynie” na oglądanie i ew. modelowanie cyfrowego obiektu 3D, o tyle AR pozwala na to samo, ale we wspomnianym rzeczywistym kontekście. Już teraz inżynier, wyposażony w gogle i rękawice VR, może podejść np. do rzeczywistego samochodu w realnej hali produkcyjnej, a AR zadba o to, by mógł dopasować do niego cyfrowy model, cyfrowy komponent, posługując się w tym celu swoimi oczami („wzmocnionymi” przez gogle) i swoimi rękami (za pośrednictwem rękawic VR), a nie zza biurka, na płaskim ekranie. A to istotnie sprawia różnicę…

I chociaż „Interakcje z wirtualnym produktem są dalekie od bycia >naturalnym<” – jak słusznie zauważa Nicolas Dalmasso z ANSYS, to na tej samej zasadzie można powiedzieć, że z cyfrowym modelem nadwozia pracuje się inaczej, niż z fizycznym modelem wykonanym z glinki. AR stanowi istotny krok naprzód w stosunku do VR i…

– (…) Może pomóc inżynierom i projektantom lepiej zrozumieć, jak opracowywany produkt zachowuje się w rzeczywistym środowisku. Na przykład podczas opracowywania systemów HVAC (ogrzewanie, wentylacja i klimatyzacja) wyświetlanie wyników CFD (obliczeniowa dynamika płynów) w urządzeniu AR na prawdziwym samochodzie naprawdę pomaga zrozumieć, w jaki sposób kształty wpływają np. na a propagację płynu… – dodaje Dalmasso.

„Wąskie gardło”

Pewną przeszkodę na tym etapie rozwoju AR stanowią ograniczenia wynikające z możliwości sprzętowych. Same urządzenia dzielą się obecnie na cztery kategorie, z których każda umożliwia wejście w świat VR/AR w ograniczonym stopniu: wyświetlacze w postaci hełmów, zewnętrzne wyświetlacze holograficzne, „inteligentne” okulary i współpracujące z wyżej wymienionymi wszelkiego rodzaju interfejsy ręczne (rękawice). Obecna technologia ma braki, które uniemożliwiają osiągnięcie pełnego potencjału urządzeń AR.

Ograniczenia w rozdzielczości, w zakresie widzenia (szerokość kąta widzenia), zniekształcenia perspektywy – wszystko daleko poniżej możliwości ludzkiego oka. Modele widziane za pośrednictwem AR, w konfrontacji z otoczeniem, pozostają modelami. Do osiągnięcia pełnego filmowego efektu, pełnego złudzenia, jeszcze wiele brakuje.

Kolejne ograniczenia dotyczą poziomu interakcji użytkownika z cyfrowym modelem, i modelu z rzeczywistym światem. Na tym etapie trudno odwzorowywać reakcje dotykowe (opór materiału, ciężar etc.), pojawiają się trudności w śledzeniu gestów, śledzeniu oka i fiksacji wzroku. Automatyczne skalowanie cyfrowego obiektu 3D do realnego otoczenia także potrafi pozostawić wiele do życzenia.

Możliwości współczesnych procesorów graficznych instalowanych w profesjonalnych stacjach roboczych, wystarczające do renderingu obiektów 3D w czasie rzeczywistym w środowisku systemów CAD 3D i na potrzeby ich wizualizacji, mają problem w sytuacji, gdy na bieżąco muszą odtwarzać dany obiekt w AR. Pamiętajmy, że liczba danych koniecznych do przetworzenia jest kilkunastokrotnie większa. A to rodzi konieczność… modyfikowania tych danych.

Typowy problem… wymiany danych

W przypadku renderingu, VR, czy AR, najczęściej model CAD zostaje przetworzony jako powierzchniowy, złożony nie z brył, ale z wielu płaskich wielokątów. Eric Kam z Essi Group zwraca uwagę na to, że liczba takich wielokątów, które można renderować w widoku 3D, jest ograniczona dostępną mocą obliczeniową procesora i karty graficznej systemu rozszerzonej rzeczywistości.

„Mimo, że teoretyczne początki AR sięgają połowy lat 60. ubiegłego stulecia, nadal jest to jedna z najmłodszych technologii wkraczających w obszary CAD.

Większość – jeśli nie wszystkie – samodzielne urządzenia mobilne i podręczne systemy AR nie mogą obsługiwać dużych modeli 3D. A przecież przetworzony model CAD, złożenie np. samochodowego silnika, składać się będzie z ogromnej liczby wielokątów (idącej w dziesiątki, jeśli nie setki milionów), co przekracza możliwości obliczeniowe urządzeń AR. Dlatego projektanci używający tych systemów muszą wykonać dodatkowy krok, optymalizując i upraszczając geometrię modeli tak, aby pasowała do wymagań wyjściowego urządzenia AR. Ten proces zmniejsza złożoność modelu CAD i umożliwia ładowanie i wykorzystywanie danych podczas przeglądania. Ten dodatkowy etap zwany jest decymowaniem, zmniejsza rozmiar modelu od 10 do 100 razy, ale – niestety – wprowadza niedokładności w reprezentacji modelu.

Integracja z CAD

Przenoszenie modeli z systemów CAD na systemy AR stało się problematyczne z wielu powodów, chociaż głównym wydają się być niewystarczające zasoby i moce obliczeniowe. Wspomniane procesy optymalizacji, zapisu modelu CAD do formatu zrozumiałego i „strawnego” dla systemów AR niosą za sobą nawet większe ryzyko utraty danych lub powstania w nich przekłamania, niż w przypadku „starych jak świat” problemów z przenoszeniem danych między różnymi systemami CAD. Przełączanie się między różnymi programami, czy nawet różnymi narzędziami podczas jednego procesu projektowego zawsze jest nieefektywne i niesie ryzyko błędów.

Rozwiązanie wydawało się oczywiste i wygląda na to, że producenci zdecydowali się po nie sięgnąć: jest nim ścisła integracja systemu CAD/CAM/CAE z rozszerzoną rzeczywistością – w obrębie jednego środowiska lub przynajmniej jednej platformy systemowej.

Solid Edge z AR?

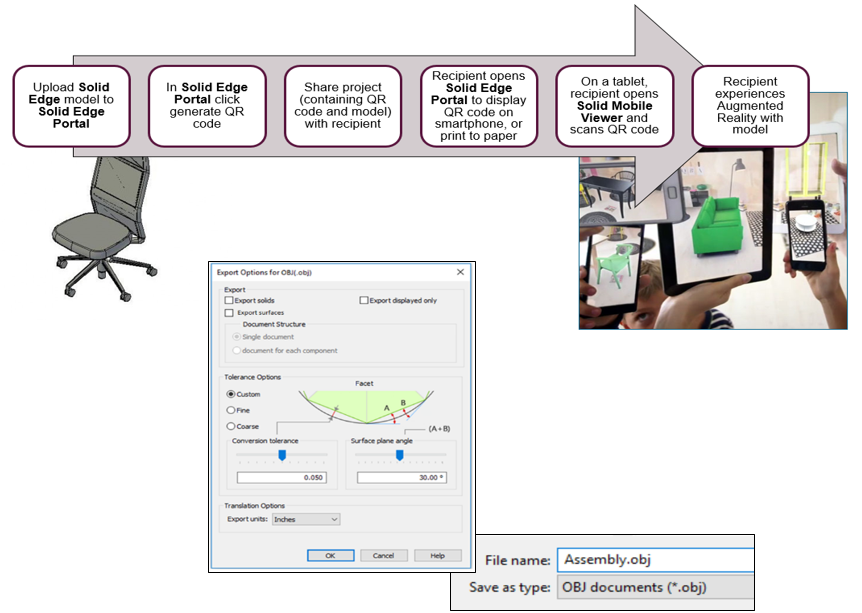

Podczas tegorocznej premiery Solid Edge 2020 firma Siemens PLM Software położyła duży nacisk na podkreślenie znaczenia i możliwości rozszerzonej rzeczywistości. Wśród kolejnych, kluczowych narzędzi nowej generacji dostępnych w najnowszej wersji Solid Edge, na pierwszym miejscu wymieniona została właśnie wizualizacja projektów w świecie AR. Jak wygląda to w praktyce? Cóż, Solid Edge pozwala zapisywać dane do uniwersalnego formatu *.obj, który stał się standardem dla rozwiązań VR/AR – na zapisane w nim dane składa się bowiem nie tylko geometria modelu, ale także dane dotyczące tekstur, koordynaty przestrzenne i inne istotne z punktu wirtualnej (i rozszerzonej) rzeczywistości. Ale to nie wszystko.

Owa zapowiadana wizualizacja modeli w AR wykracza w zasadzie poza sam Solid Edge 2020 i dotyczy… towarzyszącego mu projektowi, jakim jest Solid Edge Portal (opisywany szerzej przeze mnie m.in. na łamach CADblog.pl – link tutaj). W tym miejscu nadmienię jedynie, że Solid Edge Portal (https://solidedgeportal.sws.siemens.com/home/) jest bezpłatną platformą współpracy i wymiany danych projektowych; każdy zarejestrowany użytkownik otrzymuje do swojej dyspozycji 5GB przestrzeni dyskowej, dostęp do możliwości zintegrowanego wyświetlania modeli 3D CAD (nie tylko tych natywnych pochodzących z Solid Edge) i oczywiście narzędzia do ich przeglądania, dodawania komentarzy, adnotacji etc.).

Już w najbliższym czasie, za pośrednictwem Solid Edge Portal będziemy mogli nie tylko przesłać i udostępnić model CAD 3D, ale także wygenerować unikalny, przypisany do niego kod QR.

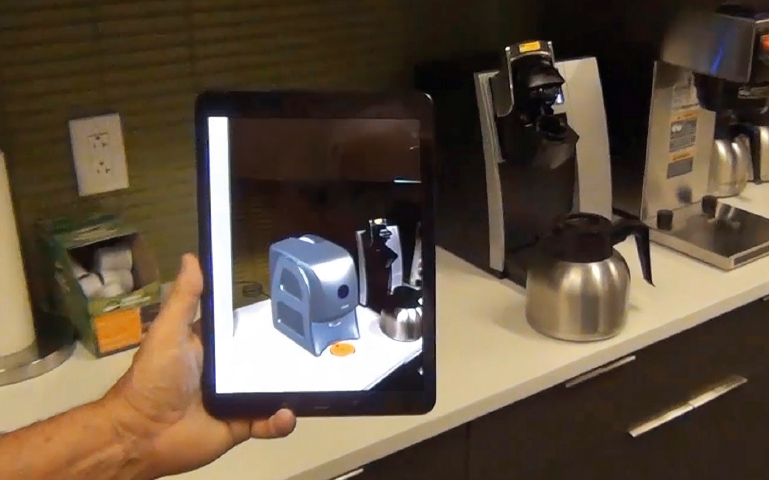

W jakim celu? Po zeskanowaniu kodu za pomocą smartfona bądź tabletu (współczesne smartfony sczytują kody QR bez potrzeby instalowania dodatkowych aplikacji), automatycznie otrzymamy model 3D dostosowany do środowiska AR i po uruchomieniu darmowej przeglądarki Solid Edge Mobile Viewer możliwe będzie oglądanie go w rzeczywistym otoczeniu (tle), w skali zbliżonej do 1:1 (o problemach ze skalowaniem wspomniałem wcześniej). Prościej chyba się nie da.

Warto podkreślić, że Siemens dodał także obsługę formatu *.obj,

co pozwala na przeniesienie dowolnego modelu z Solid Edge 2020

do zewnętrznych systemów AR/VR.

Nie tylko Siemens

Rosnące znaczenie AR wybrzmiało nie tylko przy okazji premiery najnowszej wersji Solid Edge. Podczas konferencji PTC LiveWorx 2019 w Bostonie uczestnicy mieli okazję przetestować w praktyce nowe narzędzie dedykowane zastosowaniom AR, pracujące na platformie IoT (ThingWorx), nazwane Vuforia.

– Z naszego punktu widzenia użytkownicy nie powinni się martwić o optymalizację czegokolwiek, aby skutecznie pracować w środowisku AR – mówi Luke Westbrook, specjalista ds. Zarządzania produktem w PTC. – Ale aby tak się stało, narzędzia CAD, symulacyjne i AR muszą być ściśle zintegrowane – dodaje.

ThingWorx i Vuforia ową ścisłą integrację realizują w praktyce; niedawno firma Volvo wyposażyła pracowników fabrycznych w iPady, z których pomocą pracownicy mogą nakładać na widok silnika informacje o zadaniach kontrolnych. Z kolei narzędzie Vuforia Expert Capture umożliwia pracownikom tworzenie instrukcji krok po kroku dla współpracowników, którzy wykonując zadania – na przykład ustawiając maszynę lub wykonując naprawę – noszą gogle Microsoft HoloLens (HMD).

Kolejnym krokiem naprzód ma być Vuforia Engine 8.3. Tutaj PTC stara się łączyć AR ze sztuczną inteligencją (AI). Chodzi o to, aby umożliwić automatyczne rozpoznawanie produktów lub maszyn podczas korzystania z AR (nawet przy słabym oświetleniu, lub pod niestandardowym kątem widzenia), w oparciu o model 3D CAD klienta. Równolegle PTC zaimplementowało do Creo projektowanie do wytwarzania przyrostowego i możliwość przeglądu projektu z obsługą AR.

Przykłady działań zmierzających do ściślejszej integracji systemów CAD/CAM/CAE i AR pochodzących od innych producentów (jak Autodesk, Dassaults Systemes, DS SOLIDWORKS) można mnożyć.

Spotykam się z opiniami o tym, że VR jest rywalem AR. W moim przekonaniu tak nie jest, obie te technologie rozwijane równolegle są komplementarne, ale skłaniam się do tego, że VR z czasem stanie się tylko elementem większej całości, jaką będzie rzeczywistość rozszerzona. W końcu bez VR nie byłoby AR i możemy tutaj mówić nie o rewolucji w technikach cyfrowej wizualizacji, ale o ewolucji. Planowej i konsekwentnej.

I jestem skłonny przypuszczać, że w ciągu najbliższej dekady inżynier projektant będzie miał możliwość uruchomienia z poziomu platformy VR/AR zaawansowanego systemu CAD 3D i projektowania modelu w środowisku AR, za pośrednictwem nie manipulatorów 3D, nie myszy i klawiatury, ale… rękawic i gogli.

(ms)

Artykuł powstał dla czasopisma „Stal. Metale i Nowe Technologie”

Źródła:

Autodesk, Siemens Community, Siemens PLM Software, PTC

camdivision.pl, gmsystem.pl

develop3d.com

digitalengineering247.com

Tom Kevan: Can AR Enhance Design?

Tom Kevan: Is Mixed Reality Worth a Try?

Bądź pierwszy, który skomentuje ten wpis